Архитектура NVMe Memory Tiering на платформе VMware Cloud Foundation - настройка

В этой части статей о технологии NVMe Memory Tiering (см. прошлые части тут, тут, тут, тут и тут) мы поговорим о настройке этой технологии на серверах VMware ESX инфраструктуры VCF.

На протяжении всей этой серии статей мы рассматривали важные аспекты, которые следует учитывать перед настройкой Memory Tiering, такие как проектирование, подбор размеров, совместимость, избыточность, безопасность и многое другое. Теперь пришло время применить то, чему вы научились, и оптимизировать эту функцию для вашей среды, бюджета и стратегии.

Поскольку во многих статьях подробно описаны шаги настройки, этот пост будет сосредоточен на подходе высокого уровня и будет ссылаться на предыдущие посты для конкретных разделов. Всегда полагайтесь на официальную документацию Broadcom для точных шагов настройки — официальное руководство можно найти здесь, ну а основные аспекты развертывания Memory Tiering мы описывали тут.

Шаги настройки

Технически для настройки Memory Tiering в вашей среде требуется всего два шага, но мы добавили задачи до и после настройки, чтобы обеспечить должную тщательность и проверить внедрение.

Предварительные проверки

Плотники живут по правилу «семь раз отмерь — один раз отрежь», потому что после разреза нельзя прокрутить фарш обратно. Чтобы избежать критических ошибок при настройке, мы должны сначала убедиться, что приняли правильные архитектурные решения для нашей среды.

Убедитесь, что вы ознакомились со следующим:

После того как вы приняли все эти важные решения, этап предварительных проверок включает подтверждение того, что устройства корректно отображаются на всех ESX-хостах. Вам понадобится UID каждого устройства, чтобы создать раздел, который будет использоваться Memory Tiering.

Создание разделов

Первый шаг — создание раздела для каждого NVMe-устройства. Независимо от того, разворачиваете ли вы одно устройство на хост или используете аппаратный RAID, раздел требуется на каждом логическом NVMe-устройстве.

Методы:

- ESXCLI: выполните стандартную команду esxcli (подробности тут).

- PowerShell: создайте скрипт для автоматизации процесса. Пример скрипта доступен тут, он может быть изменён под среду вашего кластера.

Частые вопросы

Вопрос: Могу ли я настроить разделы на двух устройствах без RAID на одном и том же хосте для обеспечения избыточности?

Ответ: Нет. Хотя VCF 9.0 позволяет без ошибок создавать разделы Memory Tiering на нескольких устройствах на хост, система не объединяет их и не зеркалирует данные.

Результат: Memory Tiering смонтирует только один диск, выбранный недетерминированным образом в процессе загрузки. Второй диск будет проигнорирован и не даст ни избыточности, ни увеличения ёмкости (см. будущую информацию об обновлении VCF 9.1 - там что-то может поменяться).

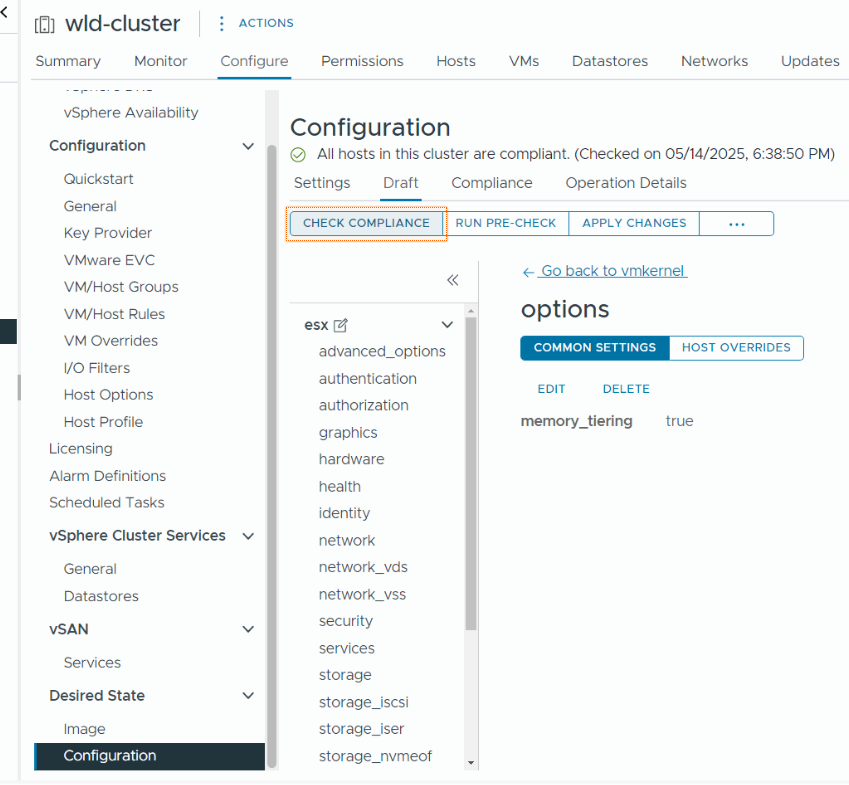

Включение Memory Tiering

Этот шаг активирует функцию Memory Tiering. Вы можете выполнить эту настройку через ESXCLI, PowerShell или интерфейс vCenter UI, применяя её к отдельным хостам или ко всему кластеру одновременно.

Вопрос: Требуется ли настраивать Memory Tiering на всех хостах в кластере VCF 9.0?

Ответ: Нет. У вас есть возможность выбрать конкретные хосты для Memory Tiering.

Хотя идеально, чтобы все хосты имели одинаковую конфигурацию, все понимают, что определённые ограничения ВМ могут потребовать исключений (см. тут).

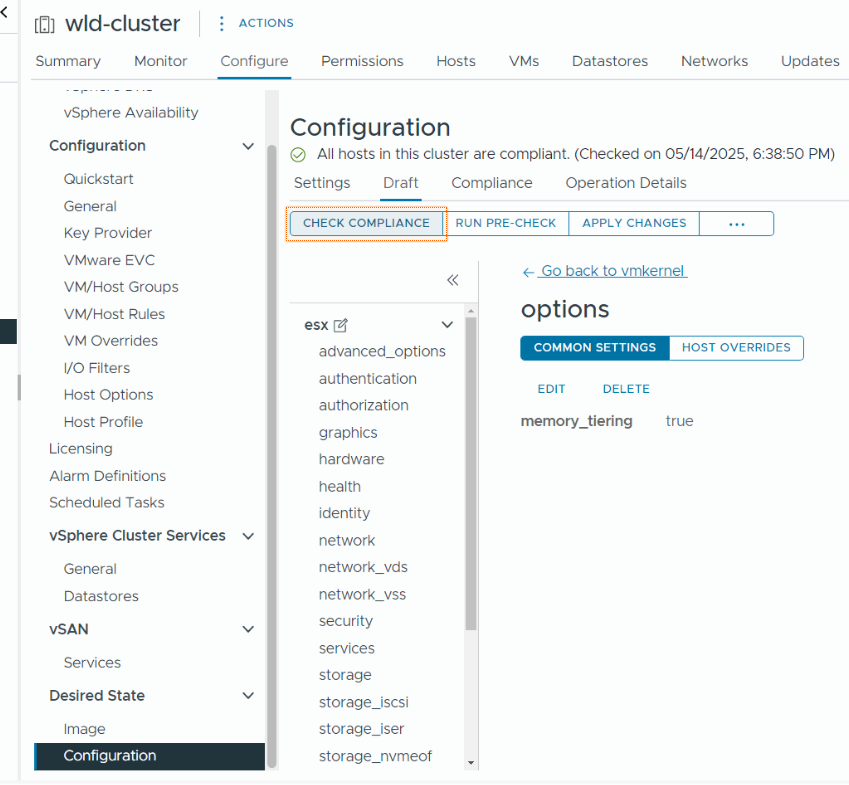

Самый эффективный способ настроить Memory Tiering — использовать профили конфигурации vSphere. Это позволяет включить функцию сразу на всех ваших хостах, одновременно используя переопределения хостов для тех хостов, где вы не хотите включать её. Подробнее — тут.

Финальный шаг

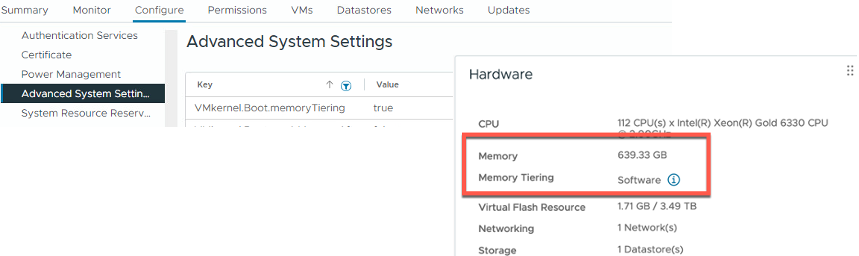

Последний шаг прост: перезагрузите все хосты и выполните проверку. В VCF/VVF 9.0 перезагрузка является обязательной, чтобы эта функция вступила в силу.

Если вы используете профили конфигурации (Configuration Profiles), система автоматизирует поочерёдные перезагрузки (одна за другой), одновременно мигрируя ВМ, чтобы они оставались в сети. И если вам интересно, обеспечивает ли этот метод также доступность данных vSAN - ответ: да.

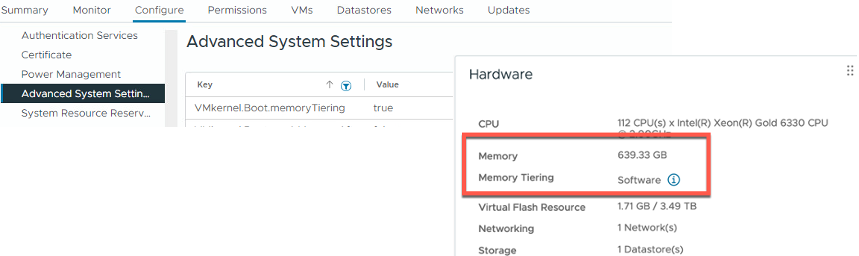

После того как все хосты снова будут онлайн, вы увидите новые элементы в интерфейсе, расположенные в разделах Advanced System Settings, на вкладке Monitor, а также Configure > Hardware > Overview > Memory.

Вы также должны увидеть, что по умолчанию объём доступной памяти увеличился в 2 раза как на уровне хоста, так и на уровне кластера. Вот это простой и недорогой способ удвоить ваш объём памяти!

В заключение: включение Memory Tiering - очень простой и понятный процесс. В качестве бонуса добавляем ссылку на актуальную лабораторную работу (Hands-on Lab), посвящённую Memory Tiering. Там вы можете выполнить настройку «от начала до конца», включая расширенные параметры, которые будут рассмотрены в следующих постах.

Таги: VMware, VCF, Memory, Tiering, Hardware

Результаты тестирования платформы VMware Cloud Foundation 9 с помощью MLPerf 5.1 для AI-нагрузок

Broadcom в сотрудничестве с Dell, Intel, NVIDIA и SuperMicro недавно продемонстрировала преимущества виртуализации, представив результаты MLPerf Inference v5.1. Платформа VMware Cloud Foundation (VCF) 9.0 показала производительность, сопоставимую с bare metal, по ключевым AI-бенчмаркам, включая Speech-to-Text (Whisper), Text-to-Video (Stable Diffusion XL), большие языковые модели (Llama 3.1-405B и Llama 2-70B), графовые нейронные сети (R-GAT) и компьютерное зрение (RetinaNet). Эти результаты были достигнуты как на GPU-, так и на CPU-решениях с использованием виртуализированных конфигураций NVIDIA с 8x H200 GPU, GPU 8x B200 в режиме passthrough/DirectPath I/O, а также виртуализированных двухсокетных процессоров Intel Xeon 6787P.

Для прямого сравнения соответствующих метрик смотрите официальные результаты MLCommons Inference 5.1. Этими результатами Broadcom вновь демонстрирует, что виртуализованные среды VCF обеспечивают производительность на уровне bare metal, позволяя заказчикам получать преимущества в виде повышенной гибкости, доступности и адаптивности, которые предоставляет VCF, при сохранении отличной производительности.

VMware Private AI — это архитектурный подход, который балансирует бизнес-выгоды от AI с требованиями организации к конфиденциальности и соответствию нормативам. Основанный на ведущей в отрасли платформе частного облака VMware Cloud Foundation (VCF), этот подход обеспечивает конфиденциальность и контроль данных, выбор между решениями с открытым исходным кодом и коммерческими AI-платформами, а также оптимальные затраты, производительность и соответствие требованиям.

Private AI позволяет предприятиям использовать широкий спектр AI-решений в своей среде — NVIDIA, AMD, Intel, проекты сообщества с открытым исходным кодом и независимых поставщиков программного обеспечения. С VMware Private AI компании могут развертывать решения с уверенностью, зная, что Broadcom выстроила партнерства с ведущими поставщиками AI-технологий. Broadcom добавляет мощь своих партнеров — Dell, Intel, NVIDIA и SuperMicro — в VCF, упрощая управление дата-центрами с AI-ускорением и обеспечивая эффективную разработку и выполнение приложений для ресурсоемких AI/ML-нагрузок.

В тестировании были показаны три конфигурации в VCF:

- SuperMicro GPU SuperServer AS-4126GS-NBR-LCC с NVLink-соединенными 8x B200 в режиме DirectPath I/O

- Dell PowerEdge XE9680 с NVLink-соединенными 8x H200 в режиме vGPU

- Конфигурация 1-node-2S-GNR_86C_ESXi_172VCPU-VM с процессорами Intel® Xeon® 6787P с 86 ядрами.

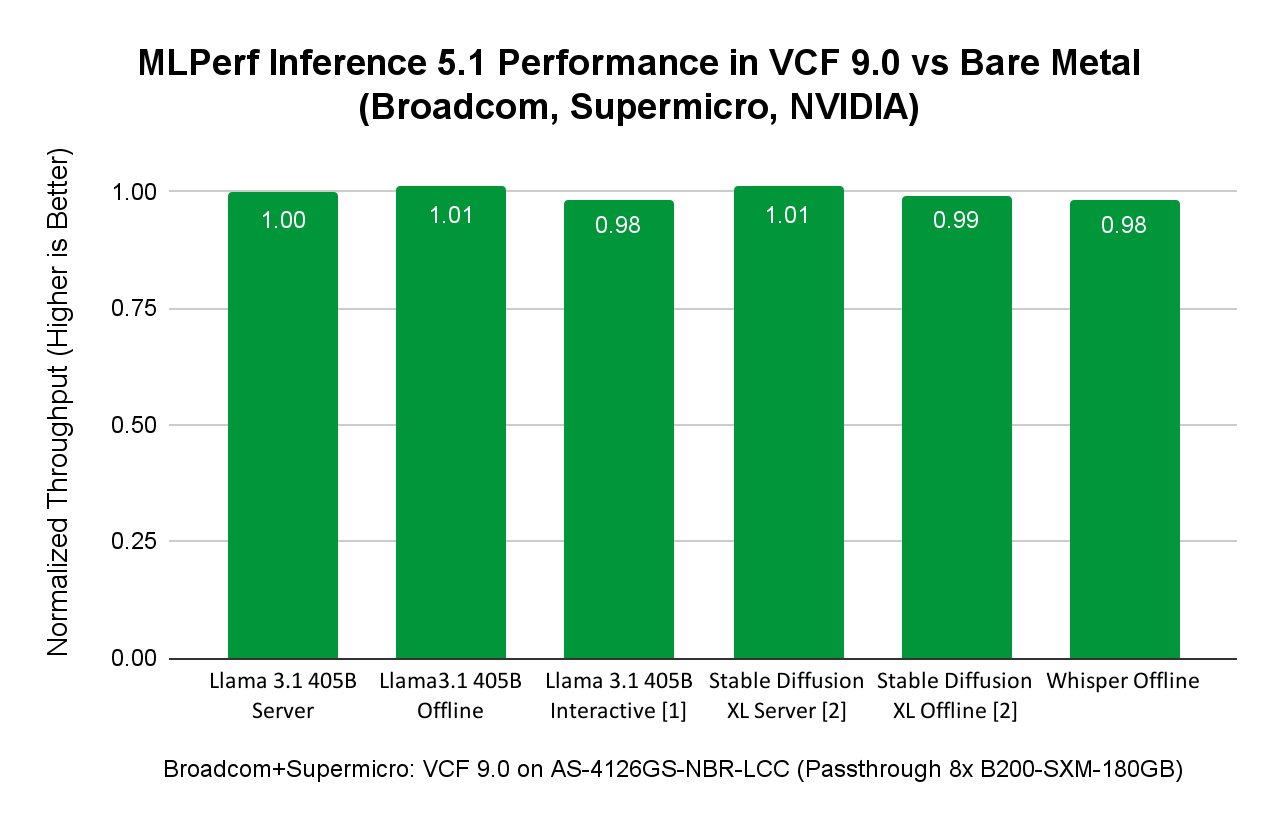

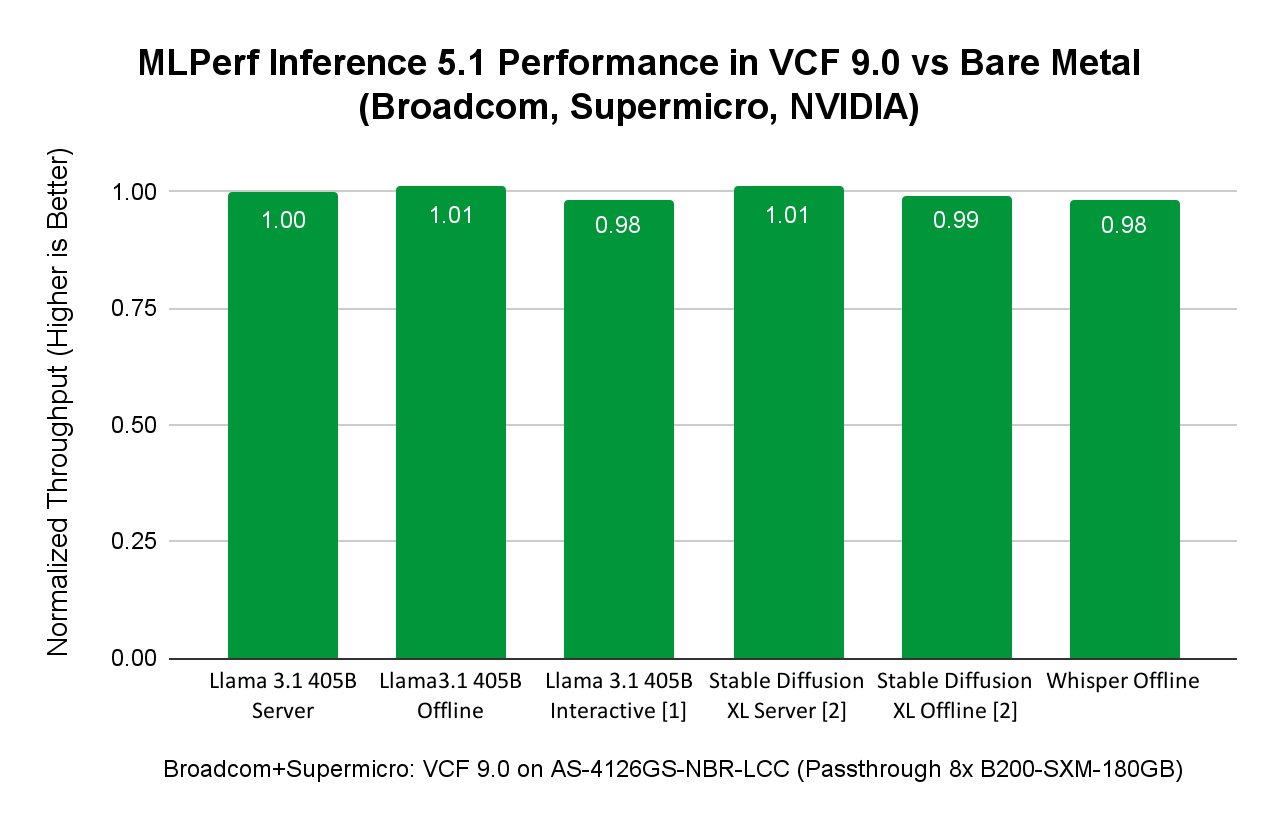

Производительность MLPerf Inference 5.1 с VCF на сервере SuperMicro с NVIDIA 8x B200

VCF поддерживает как DirectPath I/O, так и технологии NVIDIA Virtual GPU (vGPU) для использования GPU в задачах AI и других GPU-ориентированных нагрузках. Для демонстрации AI-производительности с GPU NVIDIA B200 был выбран DirectPath I/O для бенчмаркинга MLPerf Inference.

Инженеры запускали нагрузки MLPerf Inference на сервере SuperMicro SuperServer AS-4126GS-NBR-LCC с восемью GPU NVIDIA SXM B200 с 180 ГБ HBM3e при использовании VCF 9.0.0.

В таблице ниже показаны аппаратные конфигурации, использованные для выполнения нагрузок MLPerf Inference 5.1 на bare metal и виртуализированных системах. Бенчмарки были оптимизированы с помощью NVIDIA TensorRT-LLM. TensorRT-LLM включает в себя компилятор глубокого обучения TensorRT и содержит оптимизированные ядра, этапы пред- и пост-обработки, а также примитивы меж-GPU и межузлового взаимодействия, обеспечивая выдающуюся производительность на GPU NVIDIA.

| Параметр |

Bare Metal |

Виртуальная среда |

| Система |

SuperMicro GPU SuperServer SYS-422GA-NBRT-LCC |

SuperMicro GPU SuperServer AS-4126GS-NBR-LCC |

| Процессоры |

2x Intel Xeon 6960P, 72 ядра |

2x AMD EPYC 9965, 192 ядра |

| Логические процессоры |

144 |

192 из 384 (50%) выделены виртуальной машине для инференса (при загрузке CPU менее 10%). Таким образом, 192 остаются доступными для других ВМ/нагрузок с полной изоляцией благодаря виртуализации |

| GPU |

8x NVIDIA B200, 180 ГБ HBM3e |

DirectPath I/O, 8x NVIDIA B200, 180 ГБ HBM3e |

| Межсоединение ускорителей |

18x NVIDIA NVLink 5-го поколения, суммарная пропускная способность 14,4 ТБ/с |

18x NVIDIA NVLink 5-го поколения, суммарная пропускная способность 14,4 ТБ/с |

| Память |

2,3 ТБ |

Память хоста — 3 ТБ, 2,5 ТБ выделено виртуальной машине для инференса |

| Хранилище |

4x NVMe SSD по 15,36 ТБ |

4x NVMe SSD по 13,97 ТБ |

| ОС |

Ubuntu 24.04 |

ВМ Ubuntu 24.04 на VCF / ESXi 9.0.0.0.24755229 |

| CUDA |

CUDA 12.9 и драйвер 575.57.08 |

CUDA 12.8 и драйвер 570.158.01 |

| TensorRT |

TensorRT 10.11 |

TensorRT 10.11 |

Сравнение производительности виртуализованных и bare metal ML/AI-нагрузок на примере сервера SuperMicro SuperServer AS-4126GS-NBR-LCC:

Некоторые моменты:

- Результат сценария Llama 3.1 405B в интерактивном режиме не был верифицирован Ассоциацией MLCommons. Broadcom и SuperMicro не отправляли его на проверку, поскольку это не требовалось.

- Результаты Stable Diffusion XL, представленные Broadcom и SuperMicro, не могли быть напрямую сопоставлены с результатами SuperMicro на том же оборудовании, поскольку SuperMicro не отправляла результаты бенчмарка Stable Diffusion на платформе bare metal. Поэтому сравнение выполнено с другой заявкой, использующей сопоставимый хост с 8x NVIDIA B200-SXM-180GB.

Рисунок выше показывает, что AI/ML-нагрузки инференса из различных доменов — LLM (Llama 3.1 с 405 млрд параметров), Speech-to-Text (Whisper от OpenAI) и Text-to-Image (Stable Diffusion XL) — в VCF достигают производительности, сопоставимой с bare metal. При запуске AI/ML-нагрузок в VCF пользователи получают преимущества управления датацентром, предоставляемые VCF, при сохранении производительности на уровне bare metal.

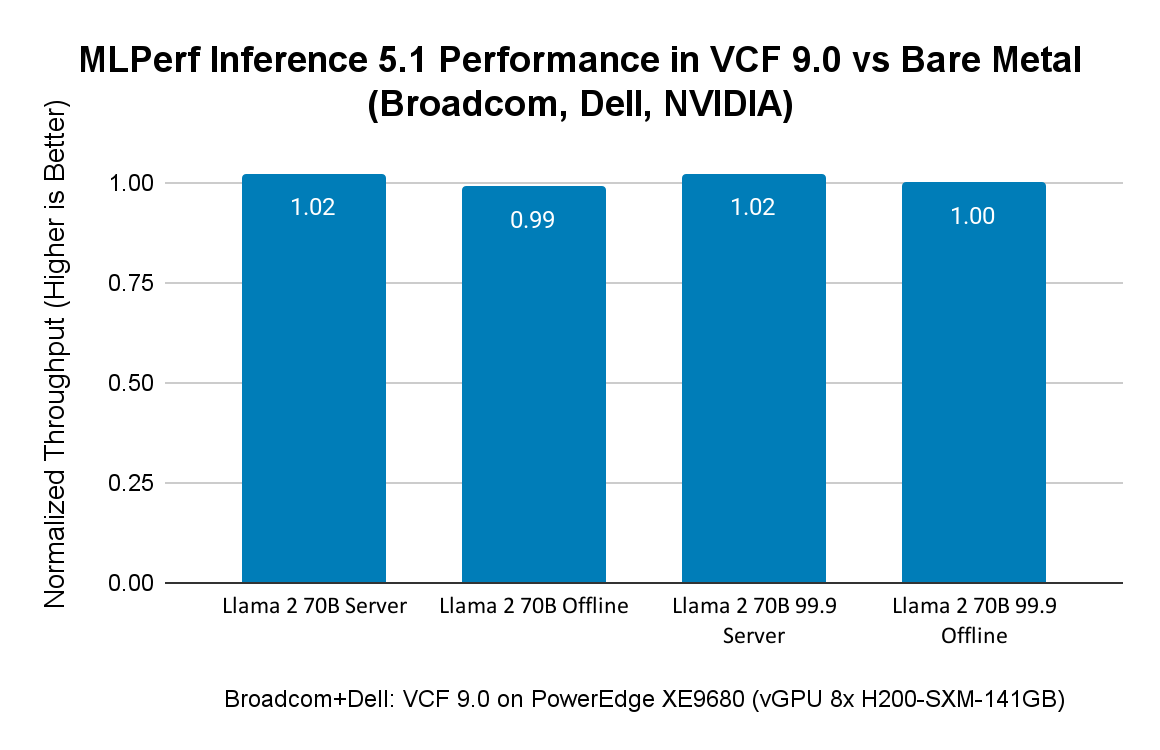

Производительность MLPerf Inference 5.1 с VCF на сервере Dell с NVIDIA 8x H200

Broadcom поддерживает корпоративных заказчиков, использующих AI-инфраструктуру от различных аппаратных вендоров. В рамках раунда заявок для MLPerf Inference 5.1, VMware совместно с NVIDIA и Dell продемонстрировала VCF 9.0 как отличную платформу для AI-нагрузок, особенно для генеративного AI. Для бенчмаркинга был выбран режим vGPU, чтобы показать еще один вариант развертывания, доступный заказчикам в VCF 9.0.

Функциональность vGPU, интегрированная с VCF, предоставляет ряд преимуществ для развертывания и управления AI-инфраструктурой. Во-первых, VCF формирует группы устройств из 2, 4 или 8 GPU с использованием NVLink и NVSwitch. Эти группы могут выделяться различным виртуальным машинам, обеспечивая гибкость распределения GPU-ресурсов в соответствии с требованиями нагрузок и повышая утилизацию GPU.

Во-вторых, vGPU позволяет нескольким виртуальным машинам совместно использовать GPU-ресурсы на одном хосте. Каждой ВМ выделяется часть памяти GPU и/или вычислительных ресурсов GPU в соответствии с профилем vGPU. Это дает возможность нескольким небольшим нагрузкам совместно использовать один GPU, исходя из их требований к памяти и вычислениям, что повышает плотность консолидации, максимизирует использование ресурсов и снижает затраты на развертывание AI-инфраструктуры.

В-третьих, vGPU обеспечивает гибкое управление дата-центрами с GPU, поддерживая приостановку/возобновление работы виртуальных машин и VMware vMotion (примечание: vMotion поддерживается только в том случае, если AI-нагрузки не используют функцию Unified Virtual Memory GPU).

И наконец, vGPU позволяет различным GPU-ориентированным нагрузкам (таким как AI, графика или другие высокопроизводительные вычисления) совместно использовать одни и те же физические GPU, при этом каждая нагрузка может быть развернута в отдельной гостевой операционной системе и принадлежать разным арендаторам в мультиарендной среде.

VMware запускала нагрузки MLPerf Inference 5.1 на сервере Dell PowerEdge XE9680 с восемью GPU NVIDIA SXM H200 с 141 ГБ HBM3e при использовании VCF 9.0.0. Виртуальным машинам в тестах была выделена лишь часть ресурсов bare metal. В таблице ниже представлены аппаратные конфигурации, использованные для выполнения нагрузок MLPerf Inference 5.1 на системах bare metal и в виртуализированной среде.

Аппаратное и программное обеспечение для Dell PowerEdge XE9680:

| Параметр |

Bare Metal |

Виртуальная среда |

| Система |

Dell PowerEdge XE9680 |

Dell PowerEdge XE9680 |

| Процессоры |

Intel Xeon Platinum 8568Y+, 96 ядер |

Intel Xeon Platinum 8568Y+, 96 ядер |

| Логические процессоры |

192 |

Всего 192, 48 (25%) выделены виртуальной машине для инференса, 144 доступны для других ВМ/нагрузок с полной изоляцией благодаря виртуализации |

| GPU |

8x NVIDIA H200, 141 ГБ HBM3e |

8x виртуализированных NVIDIA H200-SXM-141GB (vGPU) |

| Межсоединение ускорителей |

18x NVLink 4-го поколения, 900 ГБ/с |

18x NVLink 4-го поколения, 900 ГБ/с |

| Память |

3 ТБ |

Память хоста — 3 ТБ, 2 ТБ (67%) выделено виртуальной машине для инференса |

| Хранилище |

2 ТБ SSD, 5 ТБ CIFS |

2x SSD по 3,5 ТБ, 1x SSD на 7 ТБ |

| ОС |

Ubuntu 24.04 |

ВМ Ubuntu 24.04 на VCF / ESXi 9.0.0.0.24755229 |

| CUDA |

CUDA 12.8 и драйвер 570.133 |

CUDA 12.8 и драйвер Linux 570.158.01 |

| TensorRT |

TensorRT 10.11 |

TensorRT 10.11 |

Результаты MLPerf Inference 5.1, представленные в таблице, демонстрируют высокую производительность для больших языковых моделей (Llama 3.1 405B и Llama 2 70B), а также для задач генерации изображений (SDXL — Stable Diffusion).

Результаты MLPerf Inference 5.1 при использовании 8x vGPU в VCF 9.0 на аппаратной платформе Dell PowerEdge XE9680 с 8x GPU NVIDIA H200:

| Бенчмарки |

Пропускная способность |

| Llama 3.1 405B Server (токенов/с) |

277 |

| Llama 3.1 405B Offline (токенов/с) |

547 |

| Llama 2 70B Server (токенов/с) |

33 385 |

| Llama 2 70B Offline (токенов/с) |

34 301 |

| Llama 2 70B — высокая точность — Server (токенов/с) |

33 371 |

| Llama 2 70B — высокая точность — Offline (токенов/с) |

34 486 |

| SDXL Server (сэмплов/с) |

17,95 |

| SDXL Offline (сэмплов/с) |

18,64 |

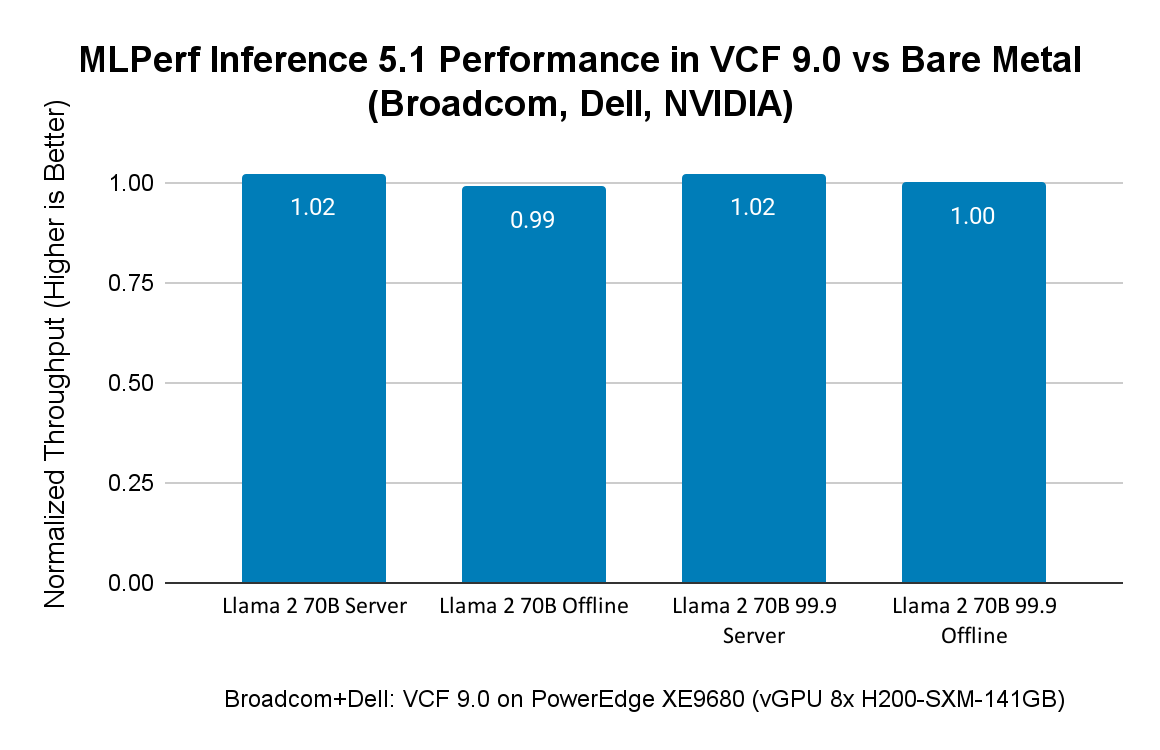

На рисунке ниже сравниваются результаты MLPerf Inference 5.1 в VCF с результатами Dell на bare metal на том же сервере Dell PowerEdge XE9680 с GPU H200. Результаты как Broadcom, так и Dell находятся в открытом доступе на сайте MLCommons. Поскольку Dell представила только результаты для Llama 2 70B, на рисунке 2 показано сравнение производительности MLPerf Inference 5.1 в VCF 9.0 и на bare metal именно для этих нагрузок. Диаграмма демонстрирует, что разница в производительности между VCF и bare metal составляет всего 1–2%.

Сравнение производительности виртуализированных и bare metal ML/AI-нагрузок на Dell XE9680 с 8x GPU H200 SXM 141 ГБ:

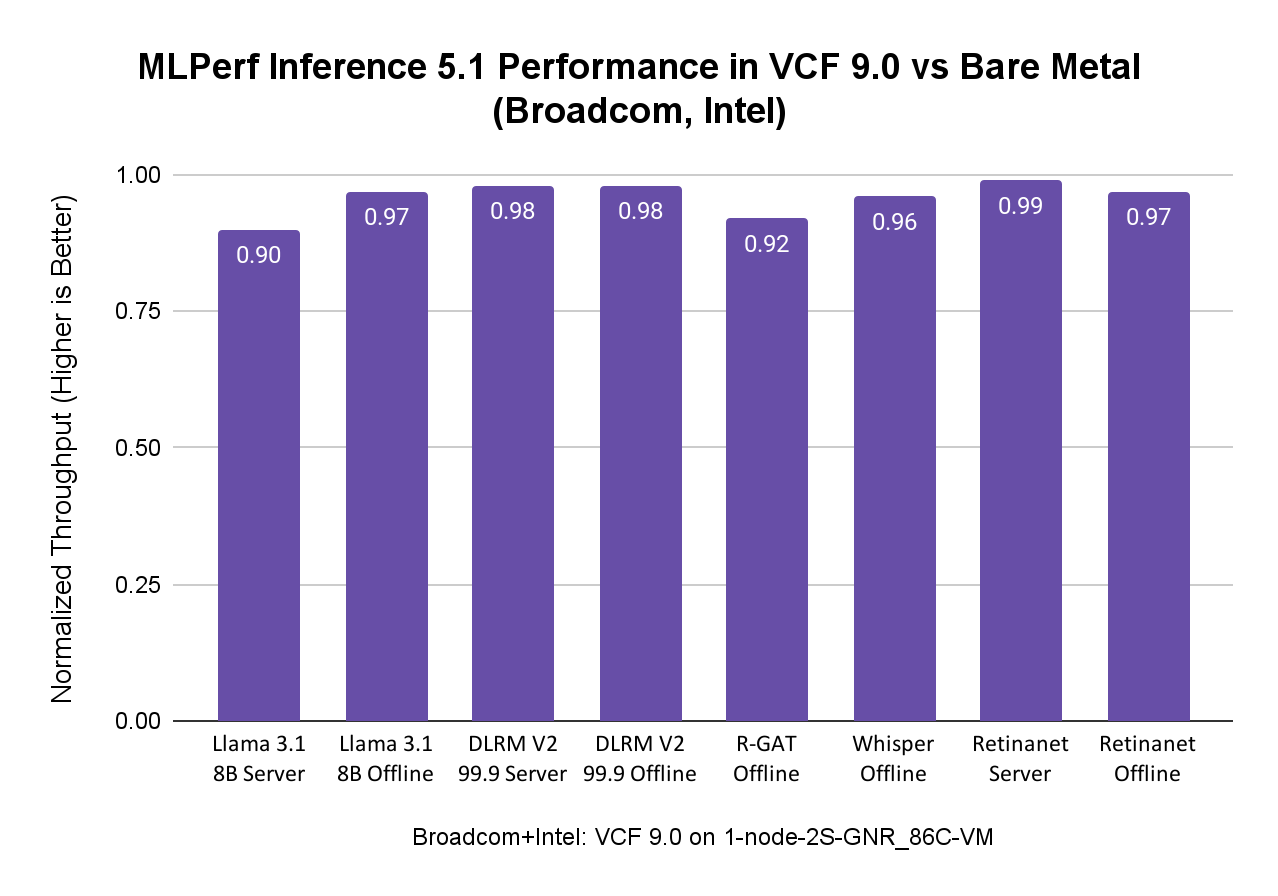

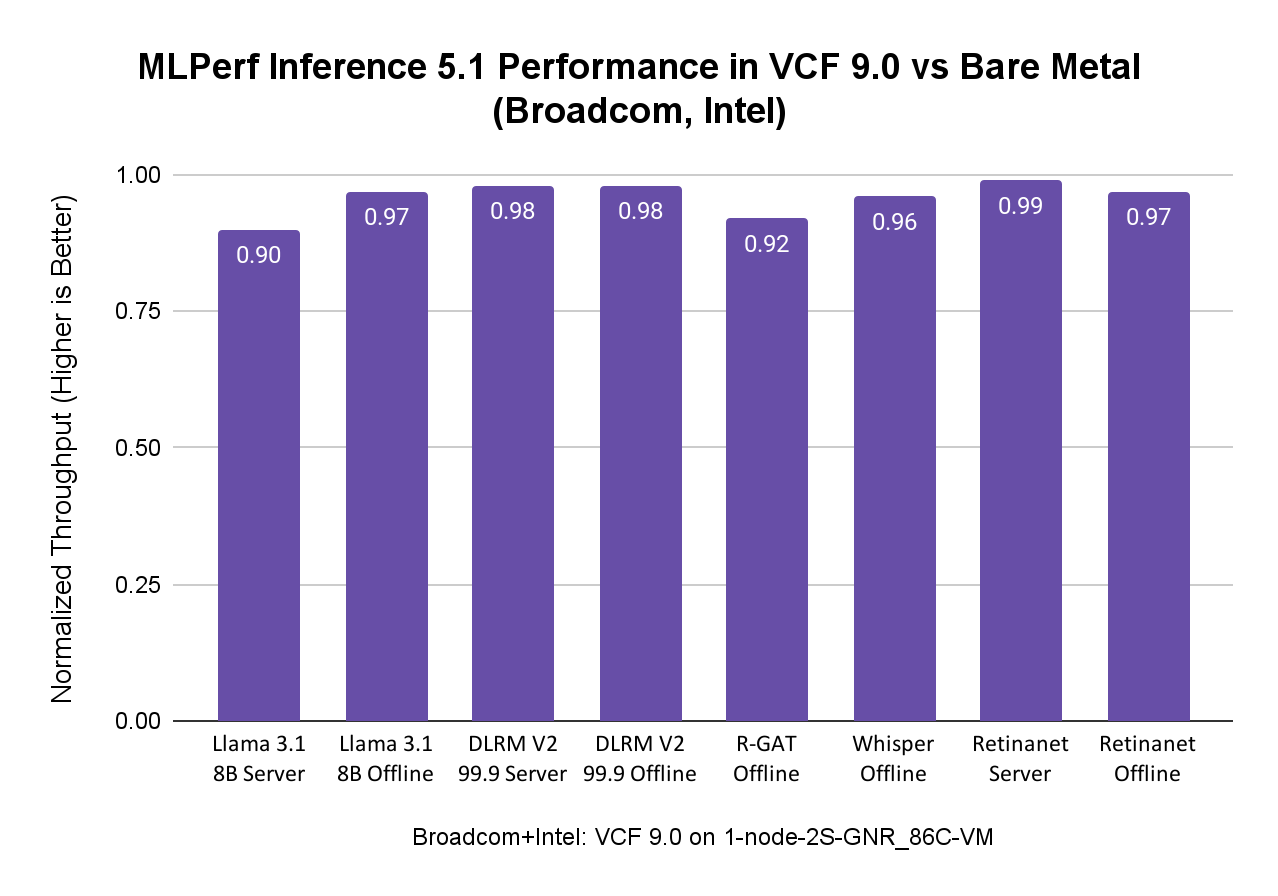

Производительность MLPerf Inference 5.1 в VCF с процессорами Intel Xeon 6-го поколения

Intel и Broadcom совместно продемонстрировали возможности VCF, ориентированные на заказчиков, использующих исключительно процессоры Intel Xeon со встроенным ускорением AMX для AI-нагрузок. В тестах запускали нагрузки MLPerf Inference 5.1, включая Llama 3.1 8B, DLRM-V2, R-GAT, Whisper и RetinaNet, на системе, представленной в таблице ниже.

Аппаратное и программное обеспечение для систем Intel

| Параметр |

Bare Metal |

Виртуальная среда |

| Система |

1-node-2S-GNR_86C_BareMetal |

1-node-2S-GNR_86C_ESXi_172VCPU-VM |

| Процессоры |

Intel Xeon 6787P, 86 ядер |

Intel Xeon 6787P, 86 ядер |

| Логические процессоры |

172 |

172 vCPU (43 vCPU на NUMA-узел) |

| Память |

1 ТБ (16x64 ГБ DDR5, 1 286 400 MT/s [8000 MT/s]) |

921 ГБ |

| Хранилище |

1x SSD 1,7 ТБ |

1x SSD 1,7 ТБ |

| ОС |

CentOS Stream 9 |

CentOS Stream 9 |

| Прочее ПО |

6.6.0-gnr.bkc.6.6.31.1.45.x86_64 |

6.6.0-gnr.bkc.6.6.31.1.45.x86_64VMware ESXi 9.0.0.0.24755229 |

AI-нагрузки, особенно модели меньшего размера, могут эффективно выполняться на процессорах Intel Xeon с ускорением AMX в среде VCF, достигая производительности, близкой к bare metal, и одновременно получая преимущества управляемости и гибкости VCF. Это делает процессоры Intel Xeon отличной отправной точкой для организаций, начинающих свой путь в области AI, поскольку они могут использовать уже имеющуюся инфраструктуру.

Результаты MLPerf Inference 5.1 при использовании процессоров Intel Xeon в VCF показывают производительность на уровне bare metal. В сценариях, где в датацентре отсутствуют ускорители, такие как GPU, или когда AI-нагрузки менее вычислительно требовательны, в зависимости от задач заказчика, AI/ML-нагрузки могут быть развернуты на процессорах Intel Xeon в VCF с преимуществами виртуализации и при сохранении производительности на уровне bare metal, как показано на рисунке ниже:

Бенчмарки MLPerf Inference

Каждый бенчмарк определяется набором данных (Dataset) и целевым уровнем качества (Quality Target). В следующей таблице приведено краткое описание бенчмарков, входящих в данную версию набора тестов (официальные правила остаются первоисточником):

| Область |

Задача |

Модель |

Набор данных |

Размер QSL |

| LLM |

LLM — вопросы и ответы |

Llama 2 70B |

OpenOrca |

24 576 |

| LLM |

Суммаризация |

Llama 3.1 8B |

CNN Dailymail (v3.00, max_seq_len = 2048) |

13 368 |

| LLM |

Генерация текста |

Llama 3.1 405B |

Подмножество LongBench, LongDataCollections, Ruler, GovReport |

8 313 |

| Зрение |

Обнаружение объектов |

RetinaNet |

OpenImages (800x800) |

64 |

| Речь |

Распознавание речи |

Whisper |

LibriSpeech |

1 633 |

| Изображения |

Генерация изображений |

SDXL 1.0 |

COCO-2014 |

5 000 |

| R-GAT |

Классификация узлов |

R-GAT |

IGBH |

788 379 |

| Commerce |

Рекомендательные системы |

DLRM-DCNv2 |

Criteo 4TB Multi-hot |

204 800 |

| Commerce |

Рекомендательные системы |

DLRM |

1TB Click Logs |

204 800 |

В сценарии Offline генератор нагрузки (LoadGen) отправляет все запросы в тестируемую систему (SUT) в самом начале прогона. В сценарии Server LoadGen отправляет новые запросы в SUT в соответствии с распределением Пуассона. Это показано в таблице ниже.

Сценарии тестирования MLPerf Inference:

| Сценарий |

Генерация запросов |

Длительность |

Сэмплов на запрос |

Ограничение по задержке |

Tail

latency |

Метрика производительности |

| Server |

LoadGen отправляет новые запросы в SUT согласно распределению Пуассона |

270 336 запросов и 60 секунд |

1 |

Зависит от бенчмарка |

99% |

Максимально поддерживаемый параметр пропускной способности Пуассона |

| Offline |

LoadGen отправляет все запросы в SUT в начале |

1 запрос и 60 секунд |

Не менее 24 576 |

Нет |

Н/Д |

Измеренная пропускная способность |

Источник: MLPerf Inference: Datacenter Benchmark Suite Results, раздел «Scenarios and Metrics».

Заключение

VCF предоставляет заказчикам несколько гибких вариантов развертывания AI-инфраструктуры, поддерживает оборудование от различных вендоров и позволяет использовать разные подходы к запуску AI-нагрузок, применяющих как GPU, так и CPU для вычислений.

При использовании GPU виртуализированные конфигурации виртуальных машин в наших бенчмарках задействуют лишь часть ресурсов CPU и памяти, при этом обеспечивая производительность MLPerf Inference 5.1 на уровне bare metal даже при пиковом использовании GPU — это одно из ключевых преимуществ виртуализации. Такой подход позволяет задействовать оставшиеся ресурсы CPU и памяти для выполнения других нагрузок с полной изоляцией, снизить стоимость AI/ML-инфраструктуры и использовать преимущества виртуализации VCF при управлении датацентрами.

Результаты бенчмарков показывают, что VCF 9.0 находится в «зоне Златовласки» для AI/ML-нагрузок, обеспечивая производительность, сопоставимую с bare metal. VCF также упрощает управление и быструю обработку нагрузок благодаря использованию vGPU, гибких NVLink-соединений между устройствами и технологий виртуализации, позволяющих применять AI/ML-инфраструктуру для графики, обучения и инференса. Виртуализация снижает совокупную стоимость владения (TCO) AI/ML-инфраструктурой, обеспечивая совместное использование дорогостоящих аппаратных ресурсов несколькими арендаторами.

Таги: VMware, AI, Hardware, VCF, Performance

Проектирование и масштабирование технологии NVMe Memory Tiering в VMware Cloud Foundation 9 с учётом безопасности и отказоустойчивости

В первой части статей этой серии мы рассмотрели некоторые предварительные требования для NVMe Memory Tiering, такие как оценка рабочих нагрузок, процент активности памяти, ограничения профилей виртуальных машин, предварительные требования и совместимость устройств NVMe.

Кроме того, мы подчеркнули важность внедрения платформы VMware Cloud Foundation (VCF) 9, которая может обеспечить значительное сокращение затрат на память, лучшее использование CPU и более высокую консолидацию виртуальных машин. Но прежде чем полностью развернуть это решение, важно спроектировать его с учётом безопасности, отказоустойчивости и масштабируемости — именно об этом и пойдёт речь в этой статье.

Безопасность

Безопасность памяти не является особенно популярной темой среди администраторов, и это объясняется тем, что память является энергонезависимой. Однако злоумышленники могут использовать память для хранения вредоносной информации на энергонезависимых носителях, чтобы избежать обнаружения — но это уже скорее тема криминалистики. Как только питание отключается, данные в DRAM (энергозависимой памяти) исчезают в течение нескольких минут. Таким образом, с NVMe Memory Tiering мы переносим страницы из энергозависимой памяти (DRAM) на энергонезависимую (NVMe).

Чтобы устранить любые проблемы безопасности, связанные с хранением страниц памяти на устройствах NVMe, VMware разработала несколько решений, которые клиенты могут легко реализовать после первоначальной настройки.

В этом первом выпуске функции Memory Tiering шифрование уже входит в комплект и готово к использованию «из коробки». Фактически, у вас есть возможность включить шифрование на уровне виртуальной машины (для каждой ВМ) или на уровне хоста (для всех ВМ на данном хосте). По умолчанию эта опция не активирована, но её легко добавить в конфигурацию через интерфейс vCenter.

Для шифрования в NVMe Memory Tiering нам не требуется система управления ключами (KMS) или встроенный поставщик ключей (NKP). Вместо этого ключ случайным образом генерируется на уровне ядра каждым хостом с использованием шифрования AES-XTS. Это избавляет от зависимости от внешних поставщиков ключей, поскольку данные, выгруженные в NVMe, актуальны только в течение времени жизни виртуальной машины.

Случайный 256-битный ключ создаётся при включении виртуальной машины, и данные шифруются в момент их выгрузки из DRAM в NVMe, а при обратной загрузке в DRAM для чтения — расшифровываются. Во время миграции виртуальной машины (vMotion) страницы памяти сначала расшифровываются, затем передаются по зашифрованному каналу vMotion на целевой хост, где генерируется новый ключ (целевым хостом) для последующих выгрузок памяти на NVMe.

Этот процесс одинаков как для «шифрования на уровне виртуальной машины», так и для «шифрования на уровне хоста» — единственное различие заключается в том, где именно применяется конфигурация.

Отказоустойчивость

Цель отказоустойчивости — повысить надёжность, сократить время простоя и, конечно, обеспечить спокойствие администратора. В контексте памяти существует несколько методов, некоторые из которых распространены больше других. В большинстве случаев для обеспечения избыточности памяти используют модули с коррекцией ошибок (ECC) и резервные модули памяти. Однако теперь, с появлением NVMe Memory Tiering, необходимо учитывать как DRAM, так и NVMe. Мы не будем подробно останавливаться на методах избыточности для DRAM, а сосредоточимся на NVMe в контексте памяти.

В VVF/VCF 9.0 функция NVMe Memory Tiering поддерживает аппаратную конфигурацию RAID, три-режимный (tri-mode) контроллер и технологию VROC (Virtual RAID on CPU) для обеспечения отказоустойчивости холодных или неактивных страниц памяти. Что касается RAID, мы не ограничиваемся какой-то одной конфигурацией: например, RAID-1 — это хорошее и поддерживаемое решение для обеспечения отказоустойчивости NVMe, но также поддерживаются RAID-5, RAID-10 и другие схемы. Однако такие конфигурации потребуют больше NVMe-устройств и, соответственно, увеличат стоимость.

Говоря о стоимости, стоит учитывать и наличие RAID-контроллеров, если вы планируете использовать RAID для отказоустойчивости. Обеспечение резервирования для холодных страниц — это архитектурное решение, которое должно приниматься с учётом баланса между затратами и операционными издержками. Что для вас важнее — надёжность, стоимость или простота эксплуатации? Также необходимо учитывать совместимость RAID-контроллера с vSAN: vSAN ESA не поддерживает RAID-контроллеры, в то время как vSAN OSA поддерживает, но они должны использоваться раздельно.

Преимущества RAID:

- Обеспечивает избыточность для NVMe как устройства памяти

- Повышает надёжность

- Возможное сокращение времени простоя

Недостатки RAID:

- Необходимость RAID-контроллера

- Дополнительные расходы

- Операционные издержки (настройка, обновление прошивок и драйверов)

- Усложнение инфраструктуры

- Появление новой точки отказа

- Возможные проблемы совместимости с vSAN, если все накопители подключены к одной общей плате (backplane)

Как видно, у аппаратной избыточности есть как плюсы, так и минусы. Следите за обновлениями — в будущем могут появиться новые поддерживаемые методы отказоустойчивости.

Теперь предположим, что вы решили не использовать RAID-контроллер. Что произойдёт, если у вас есть один выделенный накопитель NVMe для Memory Tiering, и он выйдет из строя?

Ранее мы обсуждали, что на NVMe переносятся только «холодные» страницы памяти виртуальных машин по мере необходимости. Это означает, что страницы памяти самого хоста не находятся на NVMe, а также что на накопителе может быть как много, так и мало холодных страниц — всё зависит от нагрузки на DRAM. VMware не выгружает страницы (даже холодные), если в этом нет нужды — зачем расходовать вычислительные ресурсы?

Таким образом, если часть холодных страниц была выгружена на NVMe и накопитель вышел из строя, виртуальные машины, чьи страницы находились там, могут попасть в ситуацию высокой доступности (HA). Мы говорим "могут", потому что это произойдёт только если и когда ВМ запросит эти холодные страницы обратно из NVMe, которые теперь недоступны. Если же ВМ никогда не обратится к этим страницам, она продолжит работать без сбоев.

Иными словами, сценарий отказа зависит от активности в момент сбоя NVMe:

- Если на NVMe нет холодных страниц — ничего не произойдёт.

- Если есть немного холодных страниц — возможно, несколько ВМ войдут в HA-событие и перейдут на другой хост;

- Если все холодные страницы хранились на NVMe — возможно, большинство ВМ окажутся в HA-режиме по мере запроса страниц.

Это не обязательно приведёт к полному отказу всех систем. Некоторые ВМ могут выйти из строя сразу, другие — позже, а третьи — вообще не пострадают. Всё зависит от их активности. Главное — хост ESX продолжит работу, а поведение виртуальных машин будет различаться в зависимости от текущих нагрузок.

Масштабируемость

Масштабируемость памяти — это, пожалуй, один из тех неожиданных факторов, который может обойтись очень дорого. Как известно, память составляет значительную часть (до 80%) общей стоимости нового сервера. В зависимости от подхода к закупке серверов, вы могли выбрать меньшие по объёму модули DIMM, установив их во все слоты — в этом случае у вас нет возможности увеличить объём памяти без полной замены всех модулей, а иногда даже самого сервера.

В также могли выбрать высокоплотные модули DIMM, оставив несколько слотов свободными для будущего роста — это позволяет масштабировать память, но тоже дорого, так как позже придётся докупать совместимые модули (если они ещё доступны). В обоих случаях масштабирование получается дорогим и медленным, особенно учитывая длительные процедуры утверждения бюджета и заказов в компаниях.

Именно здесь NVMe Memory Tiering показывает себя с лучшей стороны — снижая затраты и позволяя быстро увеличить объём памяти. В данном случае масштабирование памяти сводится к покупке хотя бы одного устройства NVMe и включению функции Memory Tiering — и вот у вас уже на 100% больше памяти для ваших хостов. Отличная выгода.

Можно даже «позаимствовать» накопитель из вашего хранилища vSAN, если есть возможность выделить его под Memory Tiering… но об этом чуть позже (делайте это с осторожностью).

В этой части важно понимать ограничения и возможности, чтобы обеспечить надёжность инвестиций в будущем. Мы уже говорили о требованиях к устройствам NVMe по показателям производительности и износостойкости, но что насчёт объёма NVMe-устройств? Об этом мы напишем в следующей части.

Таги: VMware, NVMe, Memory, Tiering, Hardware, Security, HA

Расширение открытой экосистемы для VMware Cloud Foundation (VCF)

Компания Broadcom объявила о продвижении «открытой, расширяемой экосистемы» для VMware Cloud Foundation (VCF), с тем чтобы пользователи могли строить, подключать, защищать и расширять свои приватные облака. Цель — дать заказчикам большую свободу выбора оборудования, сетевых архитектур и софтверных компонентов при развертывании приватного облака или облачной инфраструктуры на базе VCF.

Ключевые направления:

- Расширение аппаратной сертификации (OEM/ODM)

- Внедрение открытых сетевых конструкций (EVPN, BGP, SONiC)

- Вклад в open-source проекты (например, Kubernetes и связанные)

- Усиленные партнёрства с такими игроками как Cisco Systems, Intel Corporation, OVHcloud, Supermicro Inc., SNUC.

Архитектура и аппаратная сертификация

VCF AI ReadyNodes и ODM self-certification

Одной из ключевых инициатив является расширение программы сертификации аппаратных узлов для VCF:

- Появляются новые «VCF AI ReadyNodes» — предсертифицированные серверные конфигурации с CPU, GPU и другими ускорителями, пригодные для AI-обучения и вывода (inference).

- В программе сертификации ReadyNode для ODM-партнёров теперь предусмотрена самосертификация (ODM Partner Self-Certification) через технологическую альянс-программу Broadcom Technology Alliance Program (TAP). Вся сертифицированная система обеспечена полной совместимостью с VCF и единым жизненным циклом управления VCF.

- Поддержка edge-узлов: расширена поддержка компактных, «прочностных» (rugged) серверов для индустриальных, оборонных, розничных и удалённых площадок, что позволяет разворачивать современное приватное облако ближе к точкам генерации данных.

Технические следствия:

- Возможность применять новейшие аппаратные ускорители (GPU, FPGA и др.) под VCF, с гарантией совместимости.

- Упрощение цепочки выбора оборудования: благодаря self-certification ODM могут быстрее вывезти сертифицированные узлы, заказчик — выбрать из более широкого набора.

- Edge-варианты означают, что приватные облака не ограничены классическими ЦОД-конфигурациями, а могут быть размещены ближе к источнику данных (IoT, фабрики, розница), что важно для задержки, пропускной способности, регулирования данных.

- В совокупности это снижает TCO (Total Cost of Ownership) и ускоряет модернизацию инфраструктуры. Broadcom отмечает, что Intel, OVHcloud и др. подтверждают, что это даёт меньшее время time-to-market.

Почему это важно

Для организаций, которые строят приватные облака, часто возникает проблема «запертой» инфраструктуры: если узел не сертифицирован, риск несовместимости — обновления, жизненный цикл, поддержка. Открытая сертификация даёт больший выбор и снижает зависимость от одного производителя. При этом, с учётом AI-нагрузок и edge-инфраструктуры, требования к аппаратуре растут, и важна гарантия, что выбранный сервер будет работать под VCF без сюрпризов.

Сетевые инициативы: открытые сети и EVPN

Стратегия Broadcom в отношении сети

Broadcom объявляет стратегию объединения сетевых фабрик (network fabrics) и упрощения сетевых операций в приватном облаке через стандарты EVPN и BGP. Основные моменты:

- Поддержка сетевой интероперабельности между средами приложений и сетью: применение стандарта EVPN/BGP позволяет гибче и масштабируемее организовать сетевые фабрики.

- Цель — ускорить развертывание, дать мультивендорную гибкость, сохранить существующие сетевые инвестиции.

- Совместимость с продуктом NSX (в составе VCF) и сторонними сетевыми решениями на уровне VPC-защиты, единой сетевой операционной модели, маршрутизации и видимости.

- В рамках партнёрства с Cisco: VCF переходит к поддержке EVPN и совместимости с решением Cisco Nexus One fabric, что даёт клиентам архитектурную гибкость.

- VCF Networking (NSX) поддерживает открытый NOS (network operating system) SONiC — операционную систему для сетевых коммутаторов, основанную на Linux, на многосоставном и мультивендорном оборудовании.

Технические особенности EVPN / BGP в контексте VCF

- EVPN (Ethernet VPN) обеспечивает слой 2/3 виртуализации по IP/MPLS сетям, поддерживает VXLAN, MPLS-Over-EVPN и даёт нативную мультидоменную сегментацию.

- BGP служит как протокол контрольной плоскости для EVPN, позволяет сетям в разных локациях или доменах обмениваться маршрутами VXLAN/EVPN.

- В контексте VCF нужно, чтобы сеть поддерживала мультивендорность, работу с NSX, автоматизацию и процессы жизненного цикла. С открытым стандартом EVPN/BGP графику управления можно встроить в операции DevOps, IaC (Infrastructure as Code).

- Поддержка SONiC позволяет использовать коммутаторы «commodity» с открытым NOS, снижая затраты как CAPEX, так и OPEX: модульная архитектура, контейнеризация, возможность обновлений без простоя.

Значение для заказчика

- Возможность построить приватное облако, где сеть не является узким местом или «чёрным ящиком» вендора, а открытa и гибка по архитектуре.

- Снижение риска vendor-lock-in: можно выбирать разное сетевое оборудование, переключаться между вендорами и сохранять совместимость.

- Повышенная скорость развертывания: сертифицированные интеграции, открытые стандарты, меньше ручной настройки.

- Поддержка edge-сценариев и распределённых облаков: сетевые фабрики могут распространяться по ЦОД, филиалам, edge-узлам с единым контролем и видимостью.

Вклад в открытое программное обеспечение (Open Source)

Broadcom подчёркивает свою активность как участника сообщества облачных нативных технологий. Основные пункты:

- Компания является одним из пяти крупнейших долгосрочных контрибьюторов в Cloud Native Computing Foundation (CNCF) и вносит изменения/улучшения в проекты: Antrea, Cluster API, containerd, Contour, etcd, Harbor и другие.

- Важная веха: решение vSphere Kubernetes Service (VKS) от VMware теперь является Certified Kubernetes AI Conformant Platform — это означает, что платформа соответствует требованиям для AI-нагрузок и встроена в стандарты Kubernetes.

Техническое значение

- Совместимость с Kubernetes-экосистемой означает, что приватные облака на VCF могут использовать облачно-нативные модели: контейнеры, микро-сервисы, CI/CD, GitOps.

- AI Conformant сертификация даёт уверенность, что платформа поддерживает стандартизированную среду для AI-нагрузок (модели, фреймворки, инфраструктура).

- Работа с такими компонентами как containerd, etcd, Harbor облегчает создание, хранение, оркестрацию контейнеров и сбор образов, что важно для DevOps/DevSecOps практик.

- Интеграция с открытым стеком упрощает автоматизацию, ускоряет выход новых функций, увеличивает портируемость и мобильность рабочих нагрузок.

Пользовательские выгоды

- Организации получают возможность не просто виртуализировать нагрузки, но и расширяться в направлении «контейнеров + AI + edge».

- Более лёгкий перенос рабочих нагрузок между средами, снижение необходимости в проприетарных решениях.

- Возможность быстро реагировать на изменение требований бизнеса: добавление AI-сервиса, изменение инфраструктуры, использование микросервисов.

Практические сценарии применения

Приватное облако с AI-нагрузками

С сертифицированными AI ReadyNodes и поддержкой Kubernetes + AI Conformant платформой, заказчики могут:

- Развернуть приватное облако для обучения моделей машинного обучения/AI (CPU + GPU + ускорители) на базе VCF.

- Вывести inference-нагрузки ближе к источнику данных — например, на edge-узле в фабрике или розничном магазине.

- Использовать унифицированный стек: виртуальные машины + контейнеры + Kubernetes на одной платформе.

- Выполнить модернизацию инфраструктуры с меньшими затратами, за счёт сертификации и ПО с открытыми стандартами.

Развёртывание edge-инфраструктуры

С расширением поддержки edge-оптимизированных узлов:

- Приватное облако может распространяться за пределы ЦОД — например, на фабрики, сеть розничных точек, удалённые площадки.

- Сеть EVPN/BGP + SONiC позволяет обеспечить единое управление и видимость сетевой фабрики, даже если часть инфраструктуры находится далеко от центра.

- Заказчики в индустрии, госсекторе, рознице могут использовать эту архитектуру для низкой задержки, автономной работы, гибкой интеграции в основной ЦОД или облако.

Гетерогенная инфраструктура и мультивендорные сети

- Благодаря открытым стандартам и сертификации, заказчики не ограничены выбором одного поставщика оборудования или сети.

- Можно комбинировать разные серверные узлы (от разных OEM/ODM), разные коммутаторы и сетевой софт, и быть уверенным в интеграции с VCF.

- Это помогает снизить зависимость от единственного вендора, сделать инфраструктуру более гибкой и адаптивной к будущим изменениям.

Последствия и рекомендации

Последствия для рынка и архитектуры приватных облаков

- Увеличится конкуренция среди аппаратных и сетевых поставщиков, так как сертификация и сами архитектуры становятся более открытыми.

- Уменьшается риск «запирания» заказчиков в единой экосистеме производителя. Это способствует более быстрому внедрению инноваций: ускорители, AI-узлы, edge.

- Открытые сети и стандарты означают повышение скорости развертывания, уменьшение сложности и затрат.

- Часто частные облака превращаются в гибридные либо распределённые модели, где части инфраструктуры находятся в ЦОД, на edge, в филиалах — и такие архитектуры становятся проще благодаря инициативам Broadcom/VCF.

Что стоит учесть пользователям

- При выборе инфраструктуры приватного облака важно проверять сертифицированные конфигурации VCF ReadyNodes, чтобы быть уверенным в поддержке жизненного цикла, обновлений и совместимости.

- Если планируется AI-нагрузка — уделите внимание использованию AI ReadyNodes, поддержке GPU/ускорителей, сертификации.

- Если сеть критична (например, распределённые локации, филиалы, edge) — рассмотрите архитектуры EVPN/BGP, совместимые с NSX и мультивендорными решениями, а также возможности SONiC.

- Не забывайте об автоматизации и интеграции с облачно-нативными технологиями (Kubernetes, контейнеры, CI/CD): наличие поддержки этих технологий позволяет быстрее развивать платформу.

- Оцените TCO не только с точки зрения CAPEX (серверы, оборудование) но и OPEX (обслуживание, обновления, гибкость). Использование открытых стандартов и сертифицированных решений может снизить оба.

Заключение

Объявление Broadcom о «открытой экосистеме» для VMware Cloud Foundation — это важный шаг к тому, чтобы приватные облака стали более гибкими, адаптивными и ориентированными на будущее. Сертификация аппаратуры (в том числе для AI и edge), открытые сетевые стандарты и активный вклад в open-source проекты – всё это создаёт технологическую платформу, на которой организации могут строить современные инфраструктуры.

При этом важно помнить: открытость сама по себе не решает все проблемы — требуется грамотная архитектура, планирование жизненного цикла, взаимодействие с партнёрами и понимание, как компоненты сочетаются. Тем не менее, такие инициативы создают условия для более лёгкой и менее рисковой модернизации облачной инфраструктуры.

Таги: VMware, VCF, Hardware

Предварительные требования и совместимость оборудования для многоуровневой памяти VMware vSphere NVMe Memory Tiering

На VMware Explore 2025 в Лас-Вегасе было сделано множество анонсов, а также проведены подробные обзоры новых функций и усовершенствований, включённых в VMware Cloud Foundation (VCF) 9, включая популярную функцию NVMe Memory Tiering. Хотя эта функция доступна на уровне вычислительного компонента VCF (платформа vSphere), мы рассматриваем её в контексте всей платформы VCF, учитывая её глубокую интеграцию с другими компонентами, такими как VCF Operations, к которым мы обратимся в дальнейшем.

Memory Tiering — это новая функция, включённая в VMware Cloud Foundation, и она стала одной из основных тем обсуждения в рамках многих сессий на VMware Explore 2025. VMware заметила большой интерес и получила множество отличных вопросов от клиентов по поводу внедрения, сценариев использования и других аспектов. Эта серия статей состоит из нескольких частей, где мы постараемся ответить на наиболее частые вопросы от клиентов, партнёров и внутренних команд.

Предварительные требования и совместимость оборудования

Оценка рабочих нагрузок

Перед включением Memory Tiering крайне важно провести тщательную оценку вашей среды. Начните с анализа рабочих нагрузок в вашем датацентре, уделяя особое внимание использованию памяти. Один из ключевых показателей, на который стоит обратить внимание — активная память рабочей нагрузки.

Чтобы рабочие нагрузки подходили для Memory Tiering, общий объём активной памяти должен составлять не более 50% от ёмкости DRAM. Почему именно 50%?

По умолчанию Memory Tiering предоставляет на 100% больше памяти, то есть удваивает доступный объём. После включения функции половина памяти будет использовать DRAM (Tier 0), а другая половина — NVMe (Tier 1). Таким образом, мы стремимся, чтобы активная память умещалась в DRAM, так как именно он является самым быстрым источником памяти и обеспечивает минимальное время отклика при обращении виртуальных машин к страницам памяти. По сути, это предварительное условие, гарантирующее, что производительность при работе с активной памятью останется стабильной.

Важный момент: при оценке анализируется активность памяти приложений, а не хоста, поскольку в Memory Tiering страницы памяти ВМ переносятся (demote) на NVMe-устройство, когда становятся «холодными» или неактивными, но страницы vmkernel хоста не затрагиваются.

Как узнать объём активной памяти?

Как мы уже отметили, при использовании Memory Tiering только страницы памяти ВМ переносятся на NVMe при бездействии, тогда как системные страницы хоста остаются нетронутыми. Поэтому нам важно определить процент активности памяти рабочих нагрузок.

Это можно сделать через интерфейс vCenter в vSphere Client, перейдя в:

VM > Monitor > Performance > Advanced

Затем измените тип отображения на Memory, и вы увидите метрику Active Memory. Если она не отображается, нажмите Chart Options и выберите Active для отображения.

Обратите внимание, что метрика Active доступна только при выборе периода Real-Time, так как это показатель уровня 1 (Level 1 stat). Активная память измеряется в килобайтах (KB).

Если вы хотите собирать данные об активной памяти за более длительный период, можно сделать следующее: в vCenter Server перейдите в раздел Configure > Edit > Statistics.

Затем измените уровень статистики (Statistics Level) с Level 1 на Level 2 для нужных интервалов.

Делайте это на свой страх и риск, так как объём пространства, занимаемого базой данных, существенно увеличится. В среднем, он может вырасти раза в 3 или даже больше. Поэтому не забудьте вернуть данную настройку обратно по завершении исследования.

Также вы можете использовать другие инструменты, такие как VCF Operations или RVTools, чтобы получить информацию об активной памяти ваших рабочих нагрузок.

RVTools также собирает данные об активности памяти в режиме реального времени, поэтому убедитесь, что вы учитываете возможные пиковые значения и включаете периоды максимальной нагрузки ваших рабочих процессов.

Примечания и ограничения

Для VCF 9.0 технология Memory Tiering пока не подходит для виртуальных машин, чувствительных к задержкам (latency-sensitive VMs), включая:

- Высокопроизводительные ВМ (High-performance VMs)

- Защищённые ВМ, использующие SEV / SGX / TDX

- ВМ с включенным механизмом непрерывной доступности Fault Tolerance

- Так называемые "Monster VMs" с объёмом памяти более 1 ТБ.

В смешанных средах рекомендуется выделять отдельные хосты под Memory Tiering или отключать эту функцию на уровне отдельных ВМ. Эти ограничения могут быть сняты в будущем, поэтому стоит следить за обновлениями и расширением совместимости с различными типами нагрузок.

Программные предварительные требования

С точки зрения программного обеспечения, Memory Tiering требует новой версии vSphere, входящей в состав VCF/VVF 9.0. И vCenter, и ESX-хосты должны быть версии 9.0 или выше. Это обеспечивает готовность среды к промышленной эксплуатации, включая улучшения в области надёжности, безопасности (включая шифрование на уровне ВМ и хоста) и осведомлённости о vMotion.

Настройку Memory Tiering можно выполнить:

- На уровне хоста или кластера

- Через интерфейс vCenter UI

- С помощью ESXCLI или PowerCLI

- А также с использованием Desired State Configuration для автоматизации и последовательных перезагрузок (rolling reboots).

В VVF и VCF 9.0 необходимо создать раздел (partition) на NVMe-устройстве, который будет использоваться Memory Tiering. На данный момент эта операция выполняется через ESXCLI или PowerCLI (да, это можно автоматизировать с помощью скрипта). Для этого потребуется доступ к терминалу и включённый SSH. Позже мы подробно рассмотрим оба варианта и даже приведём готовый скрипт для автоматического создания разделов на нескольких серверах.

Совместимость NVMe

Аппаратная часть — это основа производительности Memory Tiering. Так как NVMe-накопители используются как один из уровней оперативной памяти, совместимость оборудования критически важна.

VMware рекомендует использовать накопители со следующими характеристиками:

- Выносливость (Endurance): класс D или выше (больше или равно 7300 TBW) — для высокой долговечности при множественных циклах записи.

- Производительность (Performance): класс F (100 000–349 999 операций записи/сек) или G (350 000+ операций записи/сек) — для эффективной работы механизма tiering.

Некоторые OEM-производители не указывают класс напрямую в спецификациях, а обозначают накопители как read-intensive (чтение) или mixed-use (смешанные нагрузки).

В таких случаях рекомендуется использовать Enterprise Mixed Drives с показателем не менее 3 DWPD (Drive Writes Per Day).

Если вы не знакомы с этим термином: DWPD отражает выносливость SSD и показывает, сколько раз в день накопитель может быть полностью перезаписан на протяжении гарантийного срока (обычно 3–5 лет) без отказов. Например, SSD объёмом 1 ТБ с 1 DWPD способен выдерживать 1 ТБ записей в день на протяжении гарантийного периода.

Чем выше DWPD, тем долговечнее накопитель — что критически важно для таких сценариев, как VMware Memory Tiering, где выполняется большое количество операций записи.

Также рекомендуется воспользоваться Broadcom Compatibility Guide, чтобы проверить, какие накопители соответствуют рекомендованным классам и как они обозначены у конкретных OEM-производителей. Этот шаг настоятельно рекомендуется, так как Memory Tiering может производить большие объёмы чтения и записи на NVMe, и накопители должны быть высокопроизводительными и надёжными.

Хотя Memory Tiering позволяет снизить совокупную стоимость владения (TCO), экономить на накопителях для этой функции категорически не рекомендуется.

Что касается форм-факторов, поддерживается широкий выбор вариантов. Вы можете использовать:

- Устройства формата 2.5", если в сервере есть свободные слоты.

- Вставляемые модули E3.S.

- Или даже устройства формата M.2, если все 2.5" слоты уже заняты.

Наилучший подход — воспользоваться Broadcom Compatibility Guide. После выбора нужных параметров выносливости (Endurance, класс D) и производительности (Performance, класс F или G), вы сможете дополнительно указать форм-фактор и даже параметр DWPD.

Такой способ подбора поможет вам выбрать оптимальный накопитель для вашей среды и быть уверенными, что используемое оборудование полностью соответствует требованиям Memory Tiering.

Таги: VMware, vSphere, Memory, Tiering, Performance, Hardware, NVMe

Broadcom представила инфраструктуру на базе Wi-Fi 8

В эпоху, когда AI всё чаще «уходит к краю сети» — то есть — выполняется непосредственно на устройстве или на близкой инфраструктуре, требования к беспроводным сетям меняются. Вместо гонки за пиковыми скоростями становится важнее низкая задержка, высокая надёжность, предсказуемость и адаптивность. Именно в этом контексте появляется новое поколение — Wi-Fi 8 (также обозначаемое как IEEE 802.11bn), задача которого — стать «основой» для беспроводного AI edge. Компания Broadcom представила своё семейство чипсетов Wi-Fi 8, позиционируя их как фундаментальную платформу для сетей с AI-устройствами.

Почему Wi-Fi 8 — это не про максимальную скорость?

В предыдущих поколениях Wi-Fi (например, Wi-Fi 6, Wi-Fi 6E, Wi-Fi 7) основной акцент делался на увеличение пропускной способности: больше GHz, больше антенн, более мощная модуляция. Однако в блоге Broadcom подчёркивается, что Wi-Fi 8 сменяет приоритеты: теперь главное — надёжность, предсказуемость, контроль задержки и способность работать в сложных, насыщенных средах. Другими словами: устройство может не показывать «в идеале» наибольшую скорость, но важно, чтобы оно доставляло данные вовремя, без провалов, даже если сеть нагружена.

Это особенно актуально для оконечных AI-устройств: камеры, датчики, автономные роботы, автомобили, «умный дом», промышленная автоматизация — там требуется мгновенная реакция, и беспроводная сеть не может быть слабым звеном.

Технические особенности Wi-Fi 8

Ниже — основные архитектурные и технологические моменты, которые Broadcom выделяет как отличительные черты Wi-Fi 8.

1. Телеметрия и адаптивность

Семейство чипов Wi-Fi 8 от Broadcom включает встроенные механизмы телеметрии, которые постоянно измеряют поведение сети: условия канала, загруженность, помехи, мобильность устройств. Эта информация используется в реальном времени для адаптации: например, переключение каналов, корректировка мощности, приоритизация трафика, динамическое управление потоком данных — всё с целью обеспечить низкую задержку и стабильное соединение.

2. Архитектура «краевого AI» (Edge AI)

Wi-Fi 8 позиционируется именно как платформа для Edge AI — то есть инфраструктуры, где модель, обработка данных или рекомендации выполняются ближе к устройству, а не в облаке. Broadcom подчёркивает: устройства и сети должны быть «AI-ready» — готовыми к работе с интенсивными задачами AI в режиме реального времени.

Это требует:

- Очень низкой задержки (чтобы не было «запаздывания» отклика)

- Высокой надёжности (чтобы результат был предсказуемым)

- Способности одновременно обслуживать множество устройств (IoT, сенсоры, камеры и др.)

3. Поддержка различных классов устройств и сценариев

Broadcom указывает, что Wi-Fi 8 охватывает не только домашние маршрутизаторы, но и корпоративные точки доступа, а также клиентские устройства: смартфоны, ноутбуки, автомобильные системы.

Такая универсальность важна: сеть на краю должна обслуживать разные типы устройств с разными требованиями.

4. Лицензирование стратегии и экосистема

Интересный аспект: Broadcom открывает свою платформу Wi-Fi 8 через лицензирование IP и продуктов, особенно для рынков IoT и automotive. Это позволяет партнёрам быстрее внедрять Wi-Fi 8 в новые устройства и экосистемы.

5. Стандарт IEEE 802.11bn — ориентиры

Хотя Wi-Fi 8 ещё находится в разработке (стандарт IEEE 802.11bn), уже видны ориентиры: фокус на «Ultra High Reliability» (UHR) — чрезвычайно высокая надёжность, низкая задержка, устойчивость к помехам и плотной среде.

Например, даже если физические изменения по сравнению с Wi-Fi 7 не столь радикальны, акцент смещается на качество соединения, а не просто на максимальную скорость.

Зачем Wi-Fi 8 нужен именно для Wireless AI Edge

Рассмотрим ключевые сценарии, где преимущества Wi-Fi 8 раскрываются наиболее ярко.

Сценарий: автономные системы и роботы

Представьте завод с роботами-манипуляторами, дронами, транспортными средствами на базе AI. Они генерируют, обрабатывают и обмениваются данными на месте: карты, сенсоры, объекты, навигация. Здесь задержка, потеря пакетов или нестабильность соединения — недопустимы. Wi-Fi 8 помогает обеспечить:

- Постоянное качество соединения даже при движении устройств

- Адаптацию к изменяющимся условиям канала

- Высокую плотность устройств в ограниченном пространстве

Сценарий: IP-камеры, видеоаналитика и умный дом

Камеры с AI-аналитикой могут находиться где-то между облаком и Edge. Wi-Fi 8 обеспечивает непрерывную передачу потока, реагирование на события и автономную работу без нарушения связи.

Сценарий: автомобильная и транспортная инфраструктура

Wi-Fi 8 встроен в автомобильные системы и мобильные устройства. При движении, смене точек доступа, большом количестве подключённых устройств важно, чтобы сеть была непрерывной, с минимальной задержкой, автоматически адаптировалась при смене сценария.

Так появится экосистема решений Wi-Fi 8 для домашних (BCM6718), корпоративных (BCM43840, BCM43820) и клиентских устройств (BCM43109).

Вызовы и что ещё предстоит

Хотя Wi-Fi 8 выглядит многообещающе, есть несколько моментов, на которые стоит обратить внимание.

- Стандартизация и сроки - стандарт IEEE 802.11bn ещё не окончательно утверждён; коммерческая доступность устройств и сертификация могут занять несколько лет.

Это значит, что внедрение Wi-Fi 8-решений в промышленном масштабе может состояться не сразу.

- Экосистема и совместимость - чтобы Wi-Fi 8 стал по-настоящему успешным, требуется: устройства-клиенты (смартфоны, ноутбуки, IoT-устройства), точки доступа, маршрутизаторы, инфраструктура поддержки, программные платформы. Переход всей экосистемы — задача небыстрая.

- Цена и обоснование обновлений - поскольку пиковые скорости могут не сильно отличаться от Wi-Fi 7, организациям и пользователям придётся оценивать: стоит ли обновлять оборудование сейчас ради большей надёжности и «готовности к AI Edge». Некоторые аналитики отмечают, что без заметного прироста скорости маркетинг может быть слабее.

- Безопасность и управление - с большим количеством устройств, большим количеством трафика «на краю», а также AI-нагрузками возрастает важность безопасности как на уровне устройства, так и на уровне сети. Wi-Fi 8 должен преодолеть этот вызов.

Заключение

Wi-Fi 8 от Broadcom — это не просто новое поколение беспроводного стандарта ради скорости — это полноценная платформа, ориентированная на эпоху Edge AI. Она призвана обеспечить надежную, предсказуемую, гибкую сеть, способную поддерживать устройства с AI-нагрузкой в самых требовательных сценариях.

Для организаций, которые планируют развивать инфраструктуру Edge AI, промышленный IoT, автономные системы, «умный город», Wi-Fi 8 может стать ключевым технологическим элементом. Однако, как и с любой новой технологией, важно учитывать сроки стандартизации, экосистему, реальную выгоду от обновления и стратегию внедрения.

Таги: Broadcom, Hardware, Update

Broadcom представила сетевой адаптер Thor Ultra со скоростью 800 Гбит/с

Компания Broadcom на днях объявила о выпуске Thor Ultra — первой в отрасли 800G AI Ethernet сетевой карты (NIC), способной объединять сотни тысяч XPU (eXtreme Processing Units) для выполнения AI-нагрузок с триллионами параметров. Приняв открытую спецификацию Ultra Ethernet Consortium (UEC), Thor Ultra предоставляет клиентам возможность масштабировать AI-нагрузки с экстремальной производительностью и эффективностью в открытой экосистеме.

«Thor Ultra воплощает видение Ultra Ethernet Consortium по модернизации RDMA для крупных AI-кластеров», — сказал Рам Велага, старший вице-президент и генеральный директор подразделения Core Switching Group компании Broadcom. — «Разработанная с нуля, Thor Ultra — это первый в отрасли 800G Ethernet NIC, полностью соответствующий спецификации UEC. Мы благодарны нашим клиентам за сотрудничество и нашей выдающейся инженерной команде за инновации продукта».

Традиционная RDMA не поддерживает multipathing-передачу, out-of-order доставку пакетов, выборочную повторную передачу и масштабируемый контроль перегрузок. Thor Ultra представляет революционный набор инноваций RDMA, соответствующих UEC, включая:

- Multipathing-передачу на уровне пакетов для эффективной балансировки нагрузки.

- Доставку пакетов out-of-order напрямую в память XPU для максимального использования сетевой фабрики.

- Выборочную повторную передачу для эффективной передачи данных.

- Программируемые алгоритмы контроля перегрузок на стороне приёмника и отправителя.

Thor Ultra обеспечивает высокопроизводительные расширенные возможности RDMA в открытой экосистеме. Это даёт клиентам свободу подключения любых XPU, оптики или коммутаторов и снижает зависимость от проприетарных, вертикально интегрированных решений.

Дополнительные особенности Broadcom Thor Ultra включают:

- Доступность в стандартных форм-факторах PCIe CEM и OCP 3.0.

- 200G или 100G PAM4 SerDes с поддержкой длинных пассивных медных соединений.

- Самый низкий в отрасли уровень битовых ошибок (BER) SerDes, что уменьшает разрывы соединений и ускоряет время завершения заданий (JCT).

- Интерфейс PCI Express Gen6 x16 для хоста.

- Шифрование и дешифрование на скорости линии с разгрузкой PSP, снимая с хоста/XPU вычислительно-интенсивные задачи.

- Безопасная загрузка с подписанным микропрограммным обеспечением и аттестацией устройства.

- Программируемый конвейер контроля перегрузок.

- Поддержка обрезки пакетов и сигнализации перегрузок (CSIG) с Tomahawk 5, Tomahawk 6 или любым коммутатором, совместимым с UEC.

Будучи передовой сетевой картой, Thor Ultra является ключевым дополнением к портфолио Broadcom по Ethernet-сетям для AI. В сочетании с Tomahawk 6, Tomahawk 6-Davisson, Tomahawk Ultra, Jericho 4 и Scale-Up Ethernet (SUE) Thor Ultra обеспечивает открытую экосистему для масштабных высокопроизводительных внедрений XPU.

Более подробно о сетевой карте Thor Ultra можно узнать вот тут.

Таги: Broadcom, Hardware, Networking

Новый документ: "Deploy Distributed LLM Inference with GPUDirect RDMA over InfiniBand in VMware Private AI"

На выступлении в рамках конференции Explore 2025 Крис Вулф объявил о поддержке DirectPath для GPU в VMware Private AI, что стало важным шагом в упрощении управления и масштабировании корпоративной AI-инфраструктуры. DirectPath предоставляет виртуальным машинам эксклюзивный высокопроизводительный доступ к GPU NVIDIA, позволяя организациям в полной мере использовать возможности графических ускорителей без дополнительной лицензионной сложности. Это упрощает эксперименты, прототипирование и перевод AI-проектов в производственную среду. Кроме того, VMware Private AI размещает модели ближе к корпоративным данным, обеспечивая безопасные, эффективные и экономичные развертывания. Совместно разработанное Broadcom и NVIDIA решение помогает компаниям ускорять инновации при снижении совокупной стоимости владения (TCO).

Эти достижения появляются в критически важный момент. Обслуживание передовых LLM-моделей (Large Language Models) — таких как DeepSeek-R1, Meta Llama-3.1-405B-Instruct и Qwen3-235B-A22B-thinking — на полной длине контекста зачастую превышает возможности одного сервера с 8 GPU и картой H100, что делает распределённый инференс необходимым. Агрегирование ресурсов нескольких GPU-узлов позволяет эффективно запускать такие модели, но при этом создаёт новые вызовы в управлении инфраструктурой, оптимизации межсерверных соединений и планировании рабочих нагрузок.

Именно здесь ключевую роль играет решение VMware Cloud Foundation (VCF). Это первая в отрасли платформа частного облака, которая сочетает масштаб и гибкость публичного облака с безопасностью, отказоустойчивостью и производительностью on-premises — и всё это с меньшей стоимостью владения. Используя такие технологии, как NVIDIA NVLink, NVSwitch и GPUDirect RDMA, VCF обеспечивает высокую пропускную способность и низкую задержку коммуникаций между узлами. Также гарантируется эффективное использование сетевых соединений, таких как InfiniBand (IB) и RoCEv2 (RDMA over Converged Ethernet), снижая издержки на коммуникацию, которые могут ограничивать производительность распределённого инференса. С VCF предприятия могут развернуть продуктивный распределённый инференс, добиваясь стабильной работы даже самых крупных reasoning-моделей с предсказуемыми характеристиками.

Этот пост о новом документе «Deploy Distributed LLM inference with GPUDirect RDMA over Infiniband in VMware Private AI», где приведены архитектурные рекомендации, детальные шаги развертывания и технические best practices для распределённого инференса LLM на нескольких GPU-узлах с использованием VCF и серверов NVIDIA HGX с GPUDirect RDMA по InfiniBand.

Основные моменты и технические детали

Использование серверов HGX для максимальной производительности

Серверы NVIDIA HGX играют центральную роль. Их внутренняя топология — PCIe-коммутаторы, GPU NVIDIA H100/H200 и адаптеры ConnectX-7 IB HCA — подробно описана. Критически важным условием для оптимальной производительности GPUDirect RDMA является соотношение GPU-к-NIC 1:1, что обеспечивает каждому ускорителю выделенный высокоскоростной канал.

Внутриузловая и межузловая коммуникация

NVLink и NVSwitch обеспечивают сверхбыструю связь внутри одного HGX-узла (до 8 GPU), тогда как InfiniBand или RoCEv2 дают необходимую пропускную способность и низкую задержку для масштабирования инференса на несколько серверов HGX.

GPUDirect RDMA в VCF

Включение GPUDirect RDMA в VCF требует особых настроек, таких как активация Access Control Services (ACS) в ESX и Address Translation Services (ATS) на сетевых адаптерах ConnectX-7. ATS позволяет выполнять прямые транзакции DMA между PCIe-устройствами, обходя Root Complex и возвращая производительность, близкую к bare metal, в виртуализированных средах.

Определение требований к серверам

В документ включена практическая методика для расчёта минимального количества серверов HGX, необходимых для инференса LLM. Учитываются такие факторы, как num_attention_heads и длина контекста, а также приведена справочная таблица с требованиями к аппаратному обеспечению для популярных моделей LLM (например, Llama-3.1-405B, DeepSeek-R1, Llama-4-Series, Kimi-K2 и др.). Так, для DeepSeek-R1 и Llama-3.1-405B при полной длине контекста требуется как минимум два сервера H00-HGX.

Обзор архитектуры

Архитектура решения разделена на кластер VKS, кластер Supervisor и критически важные Service VM, на которых работает NVIDIA Fabric Manager. Подчёркивается использование Dynamic DirectPath I/O, которое обеспечивает прямой доступ GPU и сетевых адаптеров (NIC) к рабочим узлам кластера VKS, в то время как NVSwitch передаётся в режиме passthrough к Service VM.

Рабочий процесс развертывания и лучшие практики

В документе рассмотрен 8-шаговый рабочий процесс развертывания, включающий:

- Подготовку аппаратного обеспечения и прошивок (включая обновления BIOS и firmware)

- Конфигурацию ESX для включения GPUDirect RDMA

- Развертывание Service VM

- Настройку кластера VKS

- Установку операторов (NVIDIA Network и GPU Operators)

- Процедуры загрузки хранилища и моделей

- Развертывание LLM с использованием SGLang и Leader-Worker Sets (LWS)

- Проверку после развертывания

Практические примеры и конфигурации

Приведены конкретные примеры, такие как:

- YAML-манифесты для развертывания кластера VKS с узлами-воркерами, поддерживающими GPU.

- Конфигурация LeaderWorkerSet для запуска моделей DeepSeek-R1-0528, Llama-3.1-405B-Instruct и Qwen3-235B-A22B-thinking на двух узлах HGX

- Индивидуально настроенные файлы топологии NCCL для максимизации производительности в виртуализированных средах

Проверка производительности

Приведены шаги для проверки работы RDMA, GPUDirect RDMA и NCCL в многосерверных конфигурациях. Также включены результаты тестов производительности для моделей DeepSeek-R1-0528 и Llama-3.1-405B-Instruct на 2 узлах HGX с использованием стресс-тестового инструмента GenAI-Perf.

Больше подробностей вы можете узнать из документа «Deploy Distributed LLM inference with GPUDirect RDMA over Infiniband in VMware Private AI».

Таги: VMware, VCF, AI, Hardware, NVIDIA, LLM, Performance, Whitepaper

Оборудование для домашней лаборатории от Вильяма Лама для развертывания VMware Cloud Foundation 9

Во время конференции VMware Explore 2025 к блогеру Вильяму Ламу, много пишущему о технологиях виртуализации по существу, обратился один из участников, которого заинтересовала его физическая сетевая инфраструктура и то, как всё подключено в его лабораторной среде VMware Cloud Foundation (VCF) 9.0. Сетевая схема ниже основана на вот этой спецификации оборудования (Hardware BOM — Build-of-Material) для VCF 9.0:

В самой лаборатории используется следующая сетевая конфигурация с дополнительными комментариями к каждому подключению в описании ниже:

Примечание: все зелёные линии на схеме выше обозначают сетевые подключения 10 GbE, а все синие линии обозначают подключения 2.5 GbE.

Порты:

- Роутер MikroTik (слева направо): порты 1–5

- Роутер Sodola (слева направо): порты 1–6

Подключения портов:

- Порт 1 на MikroTik подключен к интернет-аплинку

Это необходимо, если вам требуется исходящее подключение для установки/загрузки пакетов в вашу среду.

- Порты 2–4 на MikroTik подключены к 3 x MS-A2 через первый порт 10GbE SFP+

ESXi определит первый SFP+ порт как vmnic1.

- Порт 5 на MikroTik подключен к порту 6 (10GbE SFP+) на коммутаторе Sodola

Настроен как транковый VLAN (802.1Q), который будет передавать все VLAN’ы, определённые на MikroTik.

- Порт 1 на Sodola подключен к настольному iMac

Настроен как нетегированный VLAN, и конкретно для сети Management, чтобы можно было получить доступ ко всем системам.

- Порт 2 на Sodola подключен к ASUS NUC 14

Настроен как транковый VLAN (802.1Q) для дополнительного хоста с рабочими нагрузками VCF Workload Domain.

- Порт 5 на Sodola подключен к Synology NAS

Настроен как тегированный VLAN для доступа к VCF Offline Depot.

- Порты 3–4 на Sodola не используются и доступны для расширения системы.

Более подробно о тестовой лаборатории Вильяма можно почитать вот тут.

Таги: VMware, VCF, Hardware

Развертывание VMware Private AI на серверах HGX с использованием Broadcom Ethernet Networking

AI и генеративный AI (Gen AI) требуют значительной инфраструктуры, а задачи, такие как тонкая настройка, кастомизация, развертывание и выполнение запросов, могут сильно нагружать ресурсы. Масштабирование этих операций становится проблематичным без достаточной инфраструктуры. Кроме того, необходимо соответствовать различным требованиям в области комплаенса и законодательства в разных отраслях и странах. Решения на базе Gen AI должны обеспечивать контроль доступа, правильное размещение рабочих нагрузок и готовность к аудиту для соблюдения этих стандартов. Чтобы решить эти задачи, Broadcom представила VMware Private AI, которая помогает клиентам запускать модели рядом с их собственными данными. Объединяя инновации обеих компаний, Broadcom и NVIDIA стремятся раскрыть потенциал AI и повысить производительность при более низкой совокупной стоимости владения (TCO).

Технический документ «Развертывание VMware Private AI на серверах HGX с использованием Broadcom Ethernet Networking» подробно описывает сквозное развертывание и конфигурацию, с акцентом на DirectPath I/O (passthrough) для GPU, а также сетевые адаптеры Thor 2 с Ethernet-коммутатором Tomahawk 5. Это руководство необходимо архитекторам инфраструктуры, администраторам VCF и специалистам по data science, которые стремятся достичь оптимальной производительности своих AI-моделей в среде VCF.

Что охватывает этот документ?

Документ предоставляет детальные рекомендации по следующим направлениям:

- Адаптеры Broadcom Thor 2 и GPU NVIDIA: как эффективно интегрировать сетевые карты Broadcom и GPU NVIDIA в виртуальные машины глубокого обучения (DLVM) на базе Ubuntu в среде VMware Cloud Foundation (VCF).

- Сетевая конфигурация: пошаговые инструкции по настройке Ethernet-адаптеров Thor 2 и коммутаторов Tomahawk 5 для включения RoCE (RDMA over Converged Ethernet) с GPU NVIDIA, что обеспечивает низкую задержку и высокую пропускную способность, критически важные для AI-нагрузок.

- Тестирование производительности: процедуры запуска тестов с использованием ключевых библиотек коллективных коммуникаций, таких как NCCL, для проверки эффективности многопроцессорных GPU-операций.

- Инференс LLM: рекомендации по запуску и тестированию инференса больших языковых моделей (LLM) с помощью NVIDIA Inference Microservices (NIM) и vLLM, демонстрирующие реальный прирост производительности.

Ключевые особенности решения

Решение, описанное в документе, ориентировано на сертифицированные системы VMware Private AI на базе HGX, которые обычно оснащены 4 или 8 GPU H100/H200 с интерконнектом NVSwitch и NVLink. Целевая среда — это приватное облако на базе VCF, использующее сетевые адаптеры Broadcom 400G BCM957608 NICs и кластеризированные GPU NVIDIA H100, соединённые через Ethernet.

Ключевой аспект данного развертывания — использование DirectPath I/O для GPU и адаптеров Thor2, что обеспечивает выделенный доступ к аппаратным ресурсам и максимальную производительность. В руководстве также подробно рассматриваются следующие важные элементы:

- BIOS и прошивки: рекомендуемые конфигурации для серверов HGX, позволяющие раскрыть максимальную производительность.

- Настройки ESX: оптимизация ESX для passthrough GPU и сетевых устройств, включая корректную разметку оборудования и конфигурацию ACS (Access Control Services).

- Настройки виртуальных машин: кастомизация Deep Learning VM (DLVM) для DirectPath I/O, включая назначение статических IP и важные расширенные параметры ВМ для ускоренного запуска и повышения производительности.

Валидация производительности

- Подробные инструкции по запуску RDMA, GPUDirect RDMA с Perftest и тестов NCCL на нескольких узлах с разъяснением ожидаемой пропускной способности и задержек.

- Бенчмаркинг виртуальной и bare-metal производительности Llama-3.1-70b NIM с помощью genai-perf, позволяющий достичь результатов, близких к bare-metal.

- Использование evalscope для оценки точности и стресс-тестирования производительности передовой модели рассуждений gpt-oss-120b.

Вот интересный результат из исследования, доказывающий, что работа GPU в виртуальной среде ничем не хуже, чем в физической:

Это комплексное руководство является ценным ресурсом для всех, кто стремится развернуть и оптимизировать AI-инференс на надежной виртуальной инфраструктуре с использованием серверов NVIDIA HGX и сетевых решений Broadcom Ethernet. Следуя описанным в документе лучшим практикам, организации могут создавать масштабируемые и высокопроизводительные AI-платформы, соответствующие требованиям современных приложений глубокого обучения.

Чтобы подробнее ознакомиться с техническими деталями и процедурами развертывания, рекомендуем прочитать полный документ:

https://www.vmware.com/docs/paif-hgx-brcm-eth.

Таги: VMware, Private AI, GenAI, Performance, NVIDIA, Hardware

VMware представила Industrial vSwitch (IvS) в платформе VMware Cloud Foundation 9.0

Мир промышленной автоматизации переживает глубокую трансформацию, вызванную необходимостью повышения гибкости, эффективности и надёжности. Традиционные среды операционных технологий (OT), часто характеризующиеся жёстким, проприетарным оборудованием, эволюционируют в сторону более гибких, программно-определяемых архитектур. Broadcom находится в авангарде этой трансформации. В продолжение предыдущего анонса о поддержке Broadcom компании Audi в создании автоматизации заводов нового поколения с использованием VMware Cloud Foundation (VCF), VMware подчеркивает ключевую роль, которую играет VCF Networking в процессе модернизации Audi.

В рамках инициативы Audi Edge Cloud for Production, одним из ключевых кейсов является виртуализация физических PLC (программируемых логических контроллеров), управляющих критически важными операциями на производстве, такими как сборка автомобилей роботами. Цель — виртуализировать PLC и запускать их как виртуальные машины или контейнеры, управляемые как современные ИТ-нагрузки из частного облака Audi. Эту трансформацию поддерживает Industrial vSwitch (IvS), представленный в VCF 9.0. Разработанный в сотрудничестве с экспертами в области промышленной автоматизации, IvS приносит виртуализацию на завод, обеспечивая связь почти в реальном времени между виртуальными PLC и устройствами ввода/вывода.

Что такое Industrial vSwitch?

Industrial vSwitch (IvS) — это специализированная функция в составе NSX, работающая как распределённый сетевой коммутатор для промышленных сетей. Его основная задача — обеспечить передачу PROFINET-трафика в реальном времени на уровне 2 (L2) между устройствами с требуемой задержкой менее миллисекунды. Это обеспечивает бесшовную маршрутизацию критически важного PROFINET-трафика между виртуальными PLC (vPLC), развернутыми в VCF, и физическими устройствами ввода/вывода на производстве.

IvS основан на технологии NSX Enhanced Datapath (EDP) и разработан с учётом строгих требований промышленных систем управления: низкая задержка, минимальный джиттер и детерминированные сетевые характеристики. Производственная среда требует задержки на уровне сотен микросекунд для соответствия требованиям систем реального времени.

Основные функции

Поддержка PROFINET:

- Поддерживает протокол PROFINET DCP (обнаружение и конфигурация устройств), необходимый для настройки и управления vPLC и I/O-устройствами.

- Обрабатывает VLAN-тегирование и удаление тегов в Ethernet-кадрах PROFINET, поддерживает классы обслуживания для RT и NRT-трафика.

- Использует режим Dedicated в EDP для обработки пакетов с высоким уровнем производительности и минимальной задержкой.

Поддержка PRP (Parallel Redundancy Protocol):

- Поддерживает режим PRP RedBox, позволяющий подключать vPLC к двум независимым сетям для обеспечения отказоустойчивости.

- Отправляет управляющие кадры PRP от имени vPLC и следит за состоянием обеих сетей.

- Поддерживает взаимодействие с другими PRP-устройствами и управляет таблицами PRP Node и VDAN.

Измерение задержек:

Почему сейчас? Переход к программно-определяемому производству

Мотивация внедрения IvS очевидна: производители стремятся виртуализировать OT-среду и модернизировать цеха ради гибкости и конкурентоспособности. Ядром этой среды являются PLC. С помощью IvS возможно:

- Повысить гибкость и адаптивность производственных процессов

- Оперативно внедрять новые функции через обновления ПО

- Существенно сократить время восстановления при сбоях, повысив надёжность

- Централизованно управлять инфраструктурой

- Стандартизировать стеки приложений и обеспечить безопасность и управляемость как локально, так и удалённо

- Объединить несколько PLC на одном хосте — до 12 vPLC на систему

- Обеспечить полную отказоустойчивость с нулевым временем переключения

Архитектура и требования

ПО:

- VMware Cloud Foundation 9.0 с обновлённым NSX

- Хосты в домене нагрузки с Industrial vSwitch

Сетевые интерфейсы (NIC):

- Должны поддерживать NSX Enhanced Datapath — Dedicated

- Поддержка устройств: NVIDIA Mellanox ConnectX-6

Совместимость с ПО:

Совместимость с PRP:

Архитектура развертывания

vPLC и IvS развертываются в рамках VCF workload domain, образуя кластер управления для производственной среды. Решение интегрируется с существующими промышленными шинами (fieldbus) и заменяет традиционные аппаратные PLC. Взаимодействие с устройствами в цехе происходит через Industrial Ethernet (PROFINET). Для отказоустойчивости используется PRP, подключённый к двум сетям: LAN-A и LAN-B.

Пример развертывания

- vPLC VM размещаются в домене нагрузки VCF 9 и получают выделенные NSX VLAN-сегменты для подключения к своим ячейкам на производстве.

- IvS подключается к LAN-A и LAN-B через встроенный PRP-интерфейс и формирует PRP-каналы с коммутаторами в каждой ячейке.

- Трафик между vPLC и I/O реплицируется по обеим сетям для высокой надёжности и соответствия таймаутам.

- Коммутаторы на производстве конфигурируются как PRP RedBox, обеспечивая безотказную связь между устройствами fieldbus и vPLC.